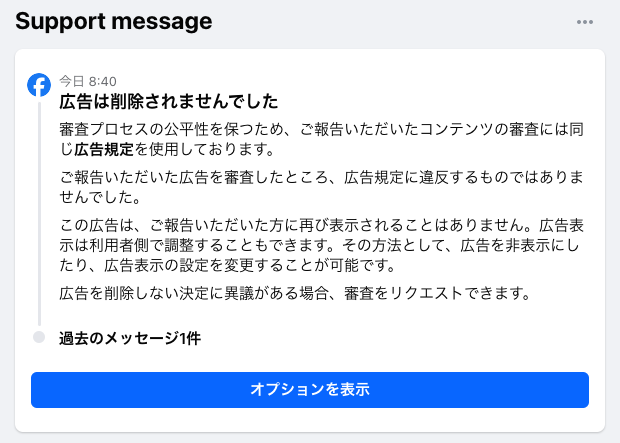

2024.04.23

あえて不便な携帯電話が発表された…。

本当に…必要なもの…大切なものとは…?

便利すぎる時代に警鐘を鳴らすのが目的?っぽいですね…。

プロモーションとしては…面白いと思います…が…

使うかなぁ…

いやぁ…やっぱり…使わないなぁ…

不便さを楽しめるくらいの余裕があれば…いいんですけどね…。

ハイネケンが平成レトロな携帯電話「The Boring Phone」を発表しました

オランダのビールメーカーであるハイネケンは、2024年4月19日、HMD GlobalとBodegaとの共同開発によるフィーチャーフォン「The Boring Phone」を発表しました。

この携帯電話は、あえて不便さを追求した点が特徴です。スマートフォンで当たり前となった高機能やインターネット接続を排除し、通話、メール、SMS、ミュージックプレーヤーといった基本的な機能のみを搭載しています。デザインも、2000年代初頭のガラケーを彷彿とさせる折りたたみ式を採用しています。

「The Boring Phone」の主な特徴

- 通話、メール、SMS、ミュージックプレーヤーといった基本的な機能のみを搭載

- インターネット接続、SNS、カメラ、アプリなどは利用不可

- 2.4インチQVGAディスプレイ

- メディアテック製チップセット

- 4GB RAM、16GB ストレージ

- 背面カメラ

- 1,400mAhバッテリー

- 3.5mmイヤホンジャック

- カラーバリエーション:ブラック、ホワイト

「The Boring Phone」の狙い

ハイネケンはこの携帯電話を、現代のデジタル社会から離れて、よりシンプルな生活を楽しむためのツールとして提案しています。「The Boring Phone」を通して、人々が本当に大切なものに目を向けるきっかけになればと考えているようです。

「The Boring Phone」の販売について

「The Boring Phone」は、一部の国・地域で期間限定で販売されます。日本での販売は未定です。

「The Boring Phone」に関する詳細情報

- 公式ウェブサイト:https://wired.jp/article/hmd-the-boring-phone-heineken-bodega/

- プレスリリース:https://www.au.com/mobile/

「The Boring Phone」の評判

「The Boring Phone」は、その斬新なコンセプトと懐かしさから、発売前から大きな注目を集めています。実際に手にした人からは、「不便さを楽しむという発想が面白い」、「デジタルデトックスに最適」、「シンプルだからこそ使いやすい」といった声が寄せられています。

一方、「価格が高い」、「機能が少なすぎる」、「実用性に欠ける」といった批判的な意見も存在します。

「The Boring Phone」の今後の展開

「The Boring Phone」が今後どのような展開を見せていくのか、注目されます。

by Gemini